阿里通义实验室多模态交互团队开源了全尺寸 GUI 智能体基座模型——MAI-UI,初次将用户交互、 MCP 对象调用、端云协同三大年夜才能经由过程自立进化数据管线和大年夜范围在线强化进修技巧,原生地集成于同一架构之中(今朝 2B 与 8B 模型已开源)。

据介绍,MAI-UI 旨在成为一个可以或许懂得和履行复杂天然说话指令、在图形用户界面(GUI)上主动完成义务的智能体。它致力于解决真实场景中的跨应用操作、模糊语义懂得、主动用户交互和多步调流程调和等挑衅。

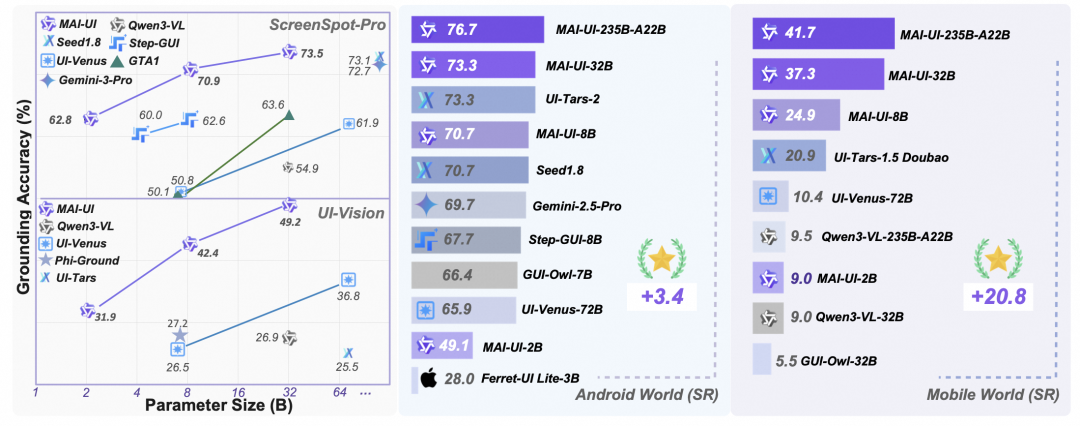

比拟传统的 AndroidWorld 测试基准,MobileWorld 测评义务更难、更真、更切近你的日常手机操作场景:

✅ 超 60% 义务需跨 App 协作(从购物比价到行程筹划)

✅ 开创两大年夜硬核挑衅:

-

✅ 平均 27.8 步长程义务(比拟 AndroidWorld 翻一倍)

智能体-用户交互式义务:用户指令模糊,须要agent主动提问澄清,拒绝幻觉。

-

MCP-GUI 混淆义务:混淆外部对象调用(如GitHub、Arxiv等)+ GUI操作,让手机迈向临盆级才能。

当前 SOTA 模型成功率仅51.7%,端到端模型最高仅 20.9%,新挑衅义务上主流 Agent 精确率近乎归零!

相干链接 :

🔗GitHub(MAI-UI):https://github.com/Tongyi-MAI/MAI-UI

🔗Arxiv(MAI-UI):http://arxiv.org/abs/2512.22047

🔗GitHub(MobileWorld):https://github.com/Tongyi-MAI/MobileWorld

🔗Arxiv(MobileWorld):https://arxiv.org/abs/2512.19432

发表评论 取消回复