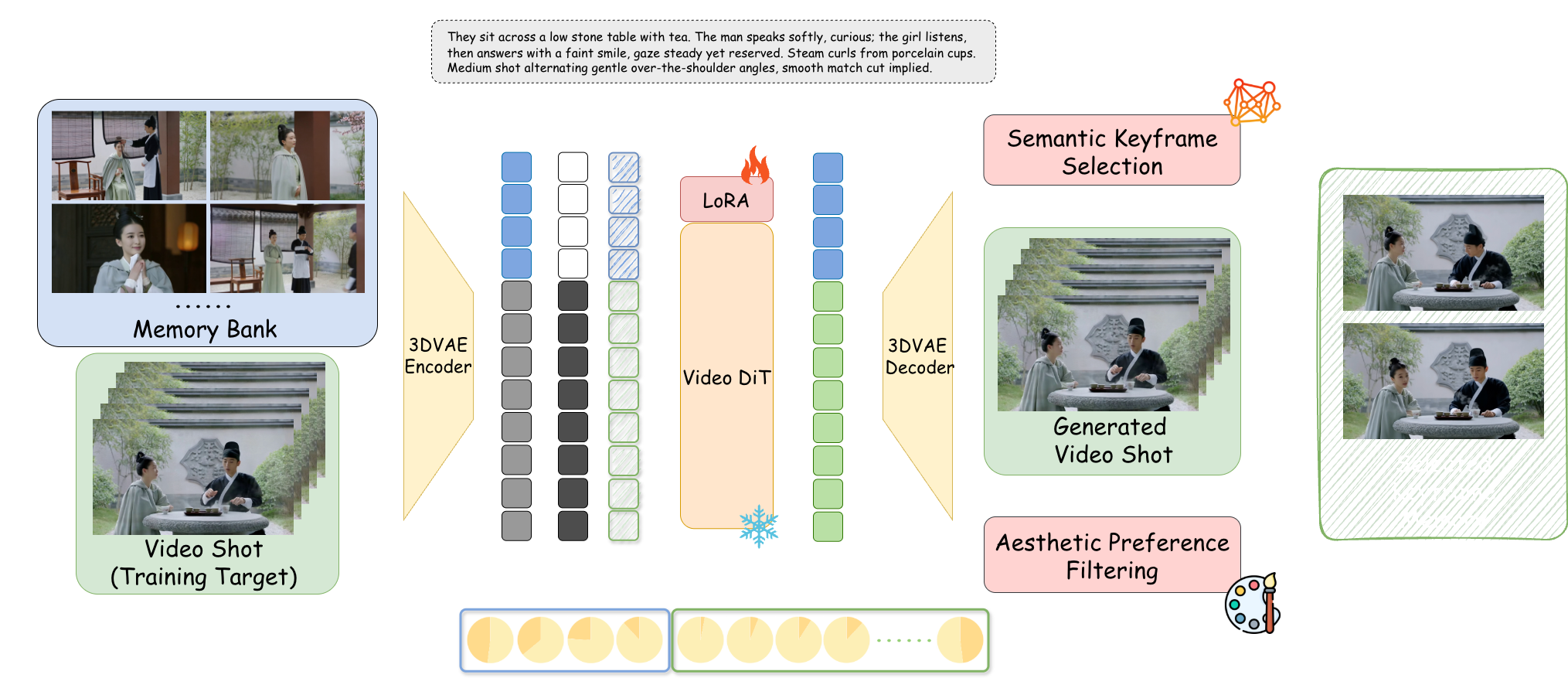

字节跳动与南洋理工大年夜学结合宣布开源AI视频生成框架StoryMem,经由过程“Memory-to-Video(M2V)”机制,将单镜头扩散模型进级为支撑多镜头、超1分钟连贯叙事的长视频生成体系。

该框架应用动态记忆库存储关键帧信息,结合轻量LoRA微调,在角色表面、场景风格和叙事逻辑上实现跨镜头高度一致,一致性指标较现有办法晋升29%。

开源地址:https://github.com/Kevin-thu/StoryMem

配套宣布的ST-Bench数据集含300个多镜头故事提示,支撑标准化评估。社区已开端在ComfyUI中集成该技巧。

发表评论 取消回复